近日,国家数据局在北京召开全国数据工作会议,会议部署2024年重点工作时提及,加快全国一体化算力网建设。会上明确,探索建设国家级数据标注基地,充分发挥地方配套支撑作用,在数据标注产业的生态构建、能力提升和场景应用等方面先行先试,集聚龙头企业,促进区域人工智能产业生态发展。

近年来,AI技术在全球范围内迅速发展,尤其是在大模型和深度学习领域取得了显著成果。然而,要实现AI技术的突飞猛进,需要大量的高质量数据集进行训练。因此,如何汇聚高质量的数据集成为了制约AI发展的关键因素。那么,AI领域专业人士如何看待此发展的重要节点?为此,中国财富专访了商汤智能产业研究院院长田丰。

数据的标注和收集是构建大数据模型的重要环节

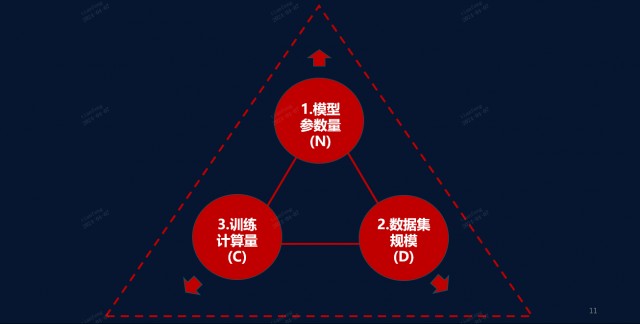

“随着AI技术的飞速发展,大模型的参数量、数据集的规模和计算量的大小逐渐成为衡量其性能的关键因素。”田丰说,“而数据标注作为这一过程中的重要环节,其规模和质量直接影响到大模型的学习性能和应用效果。”

田丰指出,中央政策不断推动数据要素的发展,数据标注的重要性日益凸显。例如,百度文心成立后,专门设立了自己的标注公司。然而,对于我国来说,数据标注行业的发展还面临着一些挑战。

首先,数据标注的规模需要大幅提升。据田丰介绍,AI 2.0的最大特点是模型变得越来越大,相应的数据训练集也要成规模地变大。“在‘大模型训练的尺度定律(Scaling Laws)’的定义下,只有当模型参数量、数据集和计算量三者同比例增长时,AI的性能才能得到突飞猛进的提升。”田丰说,“因此,汇聚中国的数据集成为一个规模性的数据集是当前的重要任务。”

供图:商汤智能产业研究院

其次,数据标注的质量也需要提高。目前,许多开发者或公司在寻找特定领域的数据时,往往面临“双盲”的情况,即需求方不知道谁有所需数据以及质量情况,供给方不知道谁需要加工好的数据资源,急需符合国家标注的“数据目录”匹配市场供需。

田丰指出,越是垂直领域的专业数据,越是当前AI模型所需要的。“以我们常见的交通数据为例,在北方,可能冰雪天气的交通数据较为常见,但暴雨暴雪等灾害天气到来时,城市基础设施承受洪涝的数据就是稀缺的。”田丰说,“但往往这些数据需求性更强。”

为了解决上述问题,国家已经开始采取行动。最近的全国数据工作会议明确指出了数据标注的重要性,并提出了一系列措施来推动其发展。其中包括建立国家数据标准中心,将各个渠道的数据汇总到一起,统一进行加工和标注。

政策端应重视成本及市场需求

田丰认为,未来,政策性倡导的数据标注行为会大幅度提高数据标注的自动化和准确率,从而有效降低数据源的生产成本,使得中小企业和开发者也能够享受到数据红利,推动AI应用创新的浪潮。“取之于民,用之于民。”田丰说。

从应用视角回看上游的数据标注以及治理层面,田丰认为政策制定者和执行者都需要注意的是成本和需求两方面。

“数据是需求,算力是供给,这一定是一体两面的关系,”田丰说,“国家在建立超大规模的AI计算中心时,应同时承载数据的处理加工和数据共享交易两种职能,分开则成本显著上升,甚至无法跑通市场闭环。”

大规模数据的汇聚需要花费巨大成本,一旦汇聚起来,搬迁将会非常昂贵甚至无法实现。因此,在数据标注以及后期的治理工作上,其必须和算力紧密结合,否则将导致产业链条分离,大大提高成本。

在需求方面,田丰认为,包括数据标注在内的数据治理各个链条上都需要了解真正的数据需求。也就是真正解决“双盲问题”。“越能满足特定数据需求的数据标注基地就越成功,像贸易繁忙的港口一样,受市场欢迎的数据标注基地的数据吞吐量会节节攀升,”田丰说,“也就是说,找到需求方真正所需要的数据,能助力产业发展。而产业发展越好,需求数据就越旺盛。”

田丰说,随着AI技术的不断发展,数据标注行业将面临更多的机遇和挑战。通过国家的政策支持和行业的共同努力,相信我国的数据标注行业将在规模和质量上取得更大的突破股票按月配资,为AI技术的发展提供更坚实的基础。